【内部分享】挖掘质量大数据赋能企业加速度

英国威廉希尔体育公司 原创

作者 | 高松 英国威廉希尔体育公司首席咨询顾问

关于“质量数字化管理”这个主题,我想跟大家分享四个话题:

一是,大数据与人工智能;

二是,大数据人工智能与质量管理;

三是,质量大数据人工智能化应用;

四是,质量大数据应用服务商的作用和责任。

近些年来,在人们生活和关注的话题当中,人工智能无疑是最为抢眼的领域。而今年,在人工智能领域最爆人眼球的事件,大概莫过于年初OpenAI发布的应用版ChatGPT-4了。人们惊呼,人工智能似乎已经不满足于只是作为人类计算与操作的延申器和加速器,而是试图代替人类思考了。

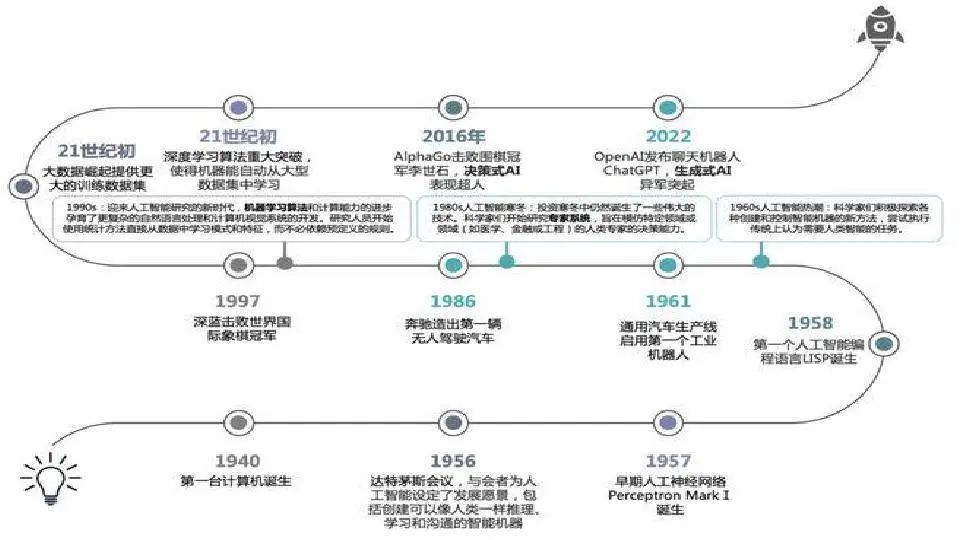

我们回顾一下人工智能的发展历史,可以与ChatGPT相提并论的事件,恐怕要数1997年IBM的“深蓝”计算机战胜国际象棋“巨人”卡斯帕罗夫,以及2016年谷歌的AlphaGo电脑程序战胜围棋世界冠军李世石。

只要我们稍微具有一点AI方面的常识的话,我们就会知道,“深蓝”、AlphaGo和ChatGPT这样的人工智能,其本质就是大数据,以及适应于大数据的计算方法和判断规则。

“深蓝”和AlphaGo被输入了人类此前几乎所有高水平的棋谱,并按照国际象棋或围棋规则编成算法,针对对手的行棋,对每一可能的应手进行计算,做出判断和决策。在计算方面,计算机每秒上千亿次上万亿次的计算速度,显然是人脑的计算能力无法企及的,人们下棋,能够算到后面三步五步即是顶尖高手,而计算机算到后面十几步甚至二十几步却易如反掌。

相对于纯粹依赖于数据计算的“深蓝”和AlphaGo来说,ChatGPT所处理的是文本,但它也是依靠大数据的。ChatGPT拥有强大的英文资源库,比如专业论文库、翻译文本库和各类聊天数据库,这些就是它的大数据资源。

当深度学习算法在本世纪初获得重大突破之后,ChatGPT就成为可能。大数据资源、深度学习算法以及相应的判断处理规则,使它有了生成新的专业论文的能力,有了撰写文案、邮件、视频脚本和编写代码以及翻译的能力,有了与人实时对话和解答问题的能力。

所有这些英文资源库,都是由海量数据构成的,数据量越是庞大,它输出的文本就越专业、越精确,甚至越深刻,俨然具有了人类的智能。

与“深蓝”和AlphaGo的数据计算能力一样,ChatGPT在成文速度和精确度方面也大大超过了人所能达到的水平。

还远远不止这些。人们日常活动的大数据也正在被利用。网上的巨额交易数据、通讯数据、交通数据等等,都已成为数字商业运营的基础。你的个人消费水平、购物偏好、阅读及观看视频的兴趣,都成为商家经营策略的向导。人类活动本身产生了大数据,而这些大数据正在为新一代人工智能产业创造着巨额的财富。

显而易见,这些海量数据之所以能够获得,是要归功于互联网的。正是互联网使得人类的活动“线上化”,而互联网的记录功能,更使得人类的活动“数据化”。现在,每一天、每一小时乃至每一分钟,在互联网上传递和运行的数据何止千亿、万亿。

“互联网、大数据、人工智能”,这大概是人类历史最近五十年来发展的最为简要的十字概括。

可是,如果我问,人类第一次有意识地、自主地使用大数据,并且在其中已经包含了当代人工智能的基本原理,这是在什么时候发生的?是起于哪一个事件?也许大家就不清楚了。

我可以告诉大家,人类第一次有意识地、自主地按照当代人工智能的基本原理使用大数据,是在整整100年前,虽然那个时候并没有人把它叫做人工智能。

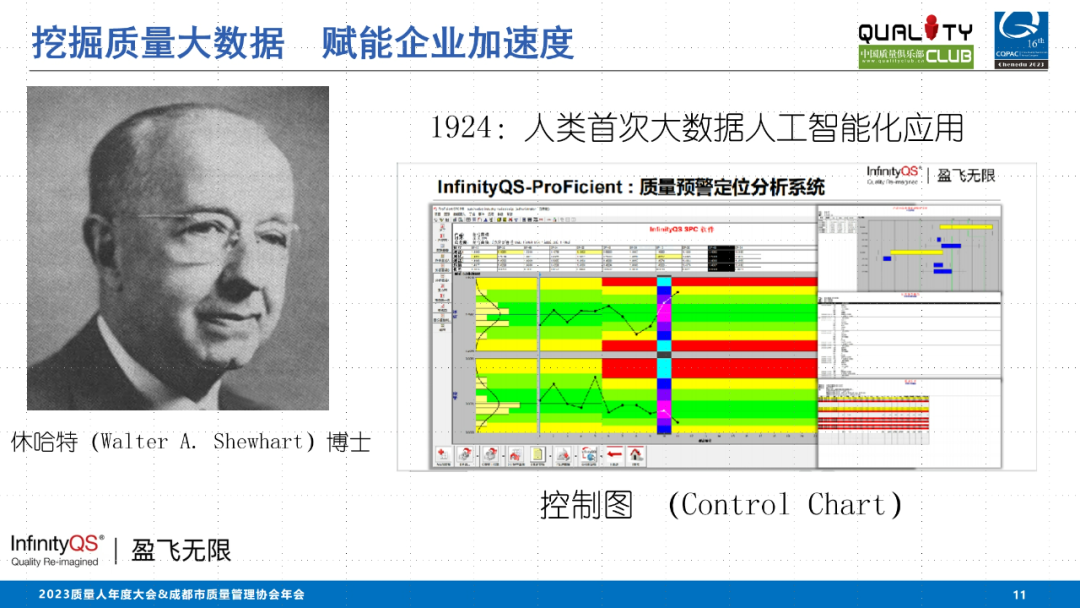

恰好是在100年前,美国统计学家休哈特(Walter A. Shewhart)博士在贝尔实验室研究并提出了“控制图(Control Chart)”,并在1924年5月16日向西方电气公司(Western Electric)提交的正式备忘录中说明了这一方法。是休哈特,看到了大规模生产背后隐藏的工业大数据,这是在互联网诞生以前,人类活动中唯一可能有效地获得的大数据资源。休哈特的Control Chart就是将生产过程大数据挖掘出来并加以标识和判断,从而为工业质量控制提供依据的方法。

作为质量人,我们也许有理由为我们自己的工作在那样久远的年代,已经首次触摸到了人工智能的前沿而感到骄傲。在这里,我们应当向休哈特大师致敬!

大家知道,工业大数据是动态的。与静态数据不同,它们一旦发生也就消失了。如果我们没有在它发生的时候捕捉到它的话。

所谓捕捉数据,就是在数据发生的时候将它们记录下来。控制图Control Chart或者说SPC,首先就是将生产过程背后隐藏的数据加以记录,然后按照控制需要对数据进行处理和判定,以评价生产过程是否处于稳定的状态,或者评估过程的趋势,从中发现可能的质量问题的征兆和线索。

在这一点上,目前对于人们日常活动大数据的应用,就比较接近SPC,只是,人们日常活动大数据的处理方法和判定规则显然还比较原始,远不如SPC那样有数理统计学严密的数学基础的支持。也就是说,它的人工智能程度是远不如SPC的。

比如,你在“拼多多”上刚刚拼了一件羽绒服,它立刻就给你推过来一大堆的羽绒服,你刚买了几包武汉的热干面,它马上又给你推来一堆的热干面……它不知道,你不可能在同时重复购买这些东西。看来,人们日常活动大数据的应用,还需要一些对于人的行为模式算法的研究,判断和处理规则也需要重新设定。

我们在这里讲的记录数据,算法以及判断和处理规则,结合在一起就叫做“数据挖掘”。

与SPC和人们日常活动大数据的应用不同,ChatGPT处理的主要是静态数据。

比如,一篇论文发布到网上,如果不是被有意删除的话,它就会一直存在在那里,人们可以随时搜索到它。对于ChatGPT来说,也就随时都可以去整理它所包含的信息数据,但这是一个枯燥而且浩繁的工作。

大家可能已经注意到,现在的大数据公司和AI公司都会招聘“数据标注员”或“数据标注师”的职位。所谓“数据标注”就是记录数据,当然是按照预定的需要记录数据,这种数据记录确切地说就是给数据赋予某种特征,或者说是定义数据。

比如分类定义、标框定义、区域定义、描点定义等等。这相当于数理统计学中的数字特征值。比如均值、中位数或众数,比如样本方差或标准偏差。

但是,正如我们刚才已经说到的,仅仅定义了特征值,还并不能实现人的控制,或者说还并不能实现人工智能的目的,想要达到人的控制或人工智能的目的,还需要有计算方法和处理判定准则,在Control Chart里,数字特征值就是计算方法。

休哈特将数据分组,并定义组内与组间的不同性质,这就是处理方法;又将均值的三倍标准差也就是3σ作为控制限,3σ就是判定准则,它们合起来就可以判断过程数据的波动性质。大家都知道,3σ的意义是,在一个限定的区间内所包含的理想数据为99.73%,或者说,一个加工过程或生产过程,如果一直稳定地保持有99.73%的制成品在它的规格限范围内,就被认为是一个稳定的或者说符合质量要求的过程。这个3σ,这个99.73%是谁规定的呢?是休哈特。是休哈特根据当时的工业生产规模及其质量控制水平规定的,实际上是一个人为的规定。

我们可以看到,Control Chart或者SPC,它是依据大数据的。它是按照数理统计原理对大数据进行计算和处理的,同时,它按照人的目的设立了判断的规则,这与现在的人工智能原理是完全一致的。

所以我说,Control Chart或者SPC是人类历史上第一次人工智能的应用,也可以说,现在的人工智能其实正是SPC的继续与扩展。

说到这里,我们似乎可以更进一步地,或者说可以从哲学的意义上来探讨一下数据的意义。所谓数据,只有当我们观察它的时候它才存在,只有当我们给予它特定的标注与赋值,同时为它设立了准则或规范的时候,也才能利用它,否则,它将毫无意义。

由此推演开去,宇宙万物或许也只是因为人而存在。是人,为所谓事物赋予特性特征,并为它设立运动法则,从而使它们具有意义。所以康德说:“人,为自然立法”。“时间”、“长度”、“重量”,甚至“数”,都是人创造的,也就是是由人赋予自然的,正是因为有了这些赋予,自然才存在。

一个事实是,大规模生产模式创造了工业大数据存在的基础,但是工业大数据是隐藏在工业生产活动背后的,而且它们转瞬即逝,一个生产过程在创造数据的同时,也在毁灭数据。这如同人们日常活动大数据的情形。

在这里我不得不遗憾地告诉大家,从休哈特提出Control Chart之后,从戴明在日本推广SPC之后,全球工业生产过程中真正被利用的大数据还不到这100年来整个工业生产规模的千分之一、万分之一,它们的99.99%都被无视、被浪费掉了。它们被丢掉了,而且无法找回,无法再现。换一个角度说,工业大数据,在理论上它们似乎应该存在过,但事实上却从来不曾存在。

这就是说,数据并非就是实在。

这话的意思是说,一方面,数据是能够消失的,另一方面,所谓数据的特征其实并非数据本身就具有的,而是由人们根据自己的设想加诸数据的。

比如,就在ChatGPT发布之后,很快,百度也发布了同样的工具,叫做“文心一言”。

不久前,当巴以爆发冲突的时候,有人就巴以冲突分别向ChatGPT和“文心一言”提出同样的问题,却得到了几乎相反的回答。毫不奇怪,ChatGPT和“文心一言”本来就是设置了不同的数据特征值和判断规则的,它们的特征值和判断规则,就分别代表了它们的设计者对于这个世界的看法。

其实,这种情形在100年前大数据第一次应用的时候,就已经发生了。

当时在贝尔实验室,除了休哈特博士之外,还有另外两位统计学家,道格和罗米格,他们也在研究如何运用数理统计学为工业生产质量提供评测的问题。

休哈特发明了Control Chart,道格和罗米格发明了抽样检验,休哈特成了统计过程控制SPC之父,而道格和罗米格也成了质量检验的鼻祖。

当二战中美国国防部急需寻找一种质量控制方法的时候,他们选择了抽样检验,并把这一方法作为“战时管理制度”的一个重要支柱。

与Control Chart或SPC错过了99.99%的工业大数据相反,抽样检验成了战后全球工业普遍采用的质量控制方法,不仅有美军标,还有国际标准,中国也早就采用了这个标准。

但是我们都知道,早在二十世纪五十年代戴明在日本就疾呼“质量不是检验”。二十世纪六十年代克劳士比在潘兴导弹生产基地也疾呼“检验产生不了质量”。而现在,“检验改变不了任何事情”已经成了人所共知的事实。

然而,过去100年,全球工业界不仅未能利用工业大数据帮助自己获得卓越的产品质量,反而将工业大数据用于徒劳无益的事后检验。这就是现实。

我们也许应该包容和接纳ChatGPT与“文心一言”之间的观念分歧,但我们却实实在在应该探究SPC与抽样检验的利与弊。

我们应当思考,我们该如何为自然立法?我们目前的立法对人类的益处何在?今天,当学术大数据、聊天大数据、生活大数据被AI紧紧抓住,创造出巨大的商业财富的时候,作为大数据应用先行者的质量大数据,是不是应该被重新审视?我们是否还会继续无视质量大数据?我们是否依然对质量大数据中隐藏着的企业提高产品质量的途径无动于衷?是否依然对其中隐藏着的巨大商业财富无动于衷?

100年来消失的工业大数据,无异于流失的黄金。这是我们面对当前的人工智能产业应当震惊,应当反思和应当有所行动的。

质量大数据需要我们去挖掘,更值得我们去挖掘,而质量大数据也会为企业发展提供巨大动能,极大地提升企业发展的加速度。

就是为了这个目的,在为企业赋能服务方面,英国威廉希尔体育公司管理软件有限公司,作为专业质量大数据应用的服务商早已做好了准备,三十多年来,我们已经为全球4000多家企业持续提供了领跑行业的功能强大的SPC专业软件系统服务,我们在经典的工业统计系列软件,比如ProFicient等工具软件的基础上,还持续推出了多种数据采集和整合系统(DMS、DCS)、远程报警监控及远程事件监控系统(RAMS、REMS)和数据库整合系统(EIS)等升级系统软件。

不仅如此,我们挖掘质量大数据的努力并没有仅仅停留在工业统计以及生产过程监控的范围里,我们还持续关注客户解决质量问题、削减质量成本和优化管理流程的根本需求。

我们知道,SPC只是告诉了我们生产过程的波动;提示了我们,生产过程可能存在的质量风险,但是,解决质量问题、消除质量风险,还需要我们进一步挖掘产品设计过程与工艺实现过程,及其试验过程的更多的技术数据资源,需要我们通过这些数据,解析质量问题发生的逻辑关系,找到它们的根本原因。

同时,我们更需要从经营的角度来审视质量问题的影响,当我们自然而然地谈论经营利润和经营成本的时候,我们也必须用金钱来衡量质量,我们想要知道,一次质量事故,它的代价是多少钱?而避免一个质量风险、解决一个质量问题,它又能为我们减少多少损失成本?增加多少经营利润?一个简捷高效的管理流程又能为我们减少多少不必要的活动?减少多少人员和物质资源的浪费?

正是基于这样的思想,像英国威廉希尔体育公司这样具有责任心与专业能力的质量大数据应用服务商,已经开发出了以优化管理流程、梳理和解决质量问题、削减损失成本、匹配行业合规要求、强化质量智能应用为目的的发展的质量管理系统DQMS(Developing QMS),这是继以质量信息管理为主的基础质量管理系统BQMS(Basic QMS)之后的又一次质量管理系统升级。

同时,我们在经典的实时SPC软件和BQMS系统培训咨询服务的基础上,已经开展了发展的质量数据应用DQMS与全流程质量管理的培训和咨询服务。

英国威廉希尔体育公司打造“经典实时SPC软件系列+BQMS与DQMS智能质量信息系统平台+专业的质量培训咨询服务”的体系,其目的就是要帮助企业在SPC之后实现真正的“质量自由”。

我们期待着与更多优秀的企业携手,共同创造高质量发展的智能工业时代。